近日,AI领域的后起之秀DeepSeek因强大的性能和独特的训练方式,引发全球AI界热议。与此同时,《哪吒2》凭借精美的特效和动人的故事,一路爆火,成为中国电影票房冠军。此前,GPT-4作为OpenAI的旗舰产品,也在全球范围内掀起了AI应用的热潮。那么,这三者在耗电量和碳排放方面如何呢?今天,我们来算算这笔账。

一、DeepSeek-V3训练的碳排放

1. DeepSeek-V3训练过程

DeepSeek-V3是一个强大的混合专家 (MoE) 语言模型。为了实现经济高效的推理和训练,其采用了多头潜在注意力 (MLA) 和 DeepSeekMoE 架构,还开创了一种无辅助损失的负载平衡策略,设置了多令牌预测(MTP)。这些设计使它能支持128K长文本处理,即可以一次性处理科研论文、长篇小说等复杂的长文本;使模型同时预测多个未来的输出token,即一次性生成多个字而非逐字生成,增强文本连贯性,大大提升代码生成、数学推理等方面的效率和性能。

2.碳排放计算

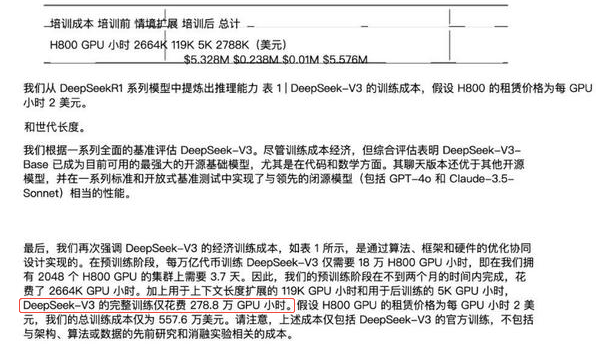

《DeepSeek-V3技术报告》部分截图

根据官方发布的技术报告,DeepSeek-V3完整训练时间为278.8万H800 GPU小时。

GPU功率:假设每块H800 GPU的功率为300瓦

单卡综合功耗:300W(显卡) × 1.3(散热损耗) = 390W

总功率:2788K GPU小时 × 0.39千瓦 =1087320 kWh≈108.7万度

全国电力平均二氧化碳排放因子:0.5366kgCO2/kWh

碳排放:1087320kWh×0.5366kgCO2/kWh= 583455.912 kg≈583.5吨

二、《哪吒2》特效制作的碳排放

1.特效制作过程

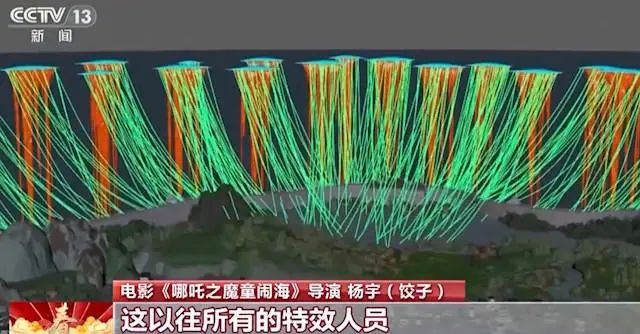

《哪吒2》的特效制作堪称“巨量级”。导演饺子为了追求完美,把特效量加到了极致,制作量相当于两到三部动画电影。影片中有1948个特效镜头,比如海底炼狱场景里,9800条动态锁链相互纠缠,每秒钟产生27万次物理碰撞运算。“洪流大战”这场戏中,更是有2亿多个角色出现在同一帧画面上。

2.碳排放计算

服务器配置:假设使用1000台服务器进行特效渲染,每台服务器功率为1.5千瓦

渲染时间:假设每天工作12小时,整个特效制作周期为1年(365天)

总功率:1000台 × 1.5千瓦 = 1500千瓦

总耗电量:1500千瓦 × 12小时 × 365天 = 6570000kWh=657万度

全国电力平均二氧化碳排放因子:0.5366kgCO2/kWh

碳排放:6570000kWh ×0.5366kgCO2/kWh= 3525462 kg ≈3525吨

三、GPT-4训练的碳排放

美国OpenAI训练大语言模型GPT-4时,为了完成一次训练,需要使用大约25000块英伟达A100 GPU,并且整个训练过程需要约三个月的时间,折合54M A100 GPU小时。它的训练用的是A100 80 GB显卡,峰值功耗为400瓦,稳定工作的功耗大约为250W到300W。按300W的功耗计算,GPT-4完整训练一次需要耗电1620万千瓦时,换算为碳排放8692920kg,约为8692吨。

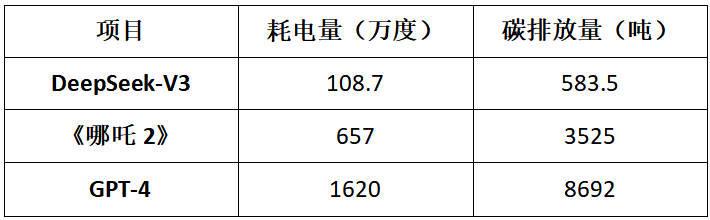

四、数据对比分析

通过上述数据可以看出,DeepSeek-V3训练的碳排放最低,约为《哪吒2》的17%、GPT-4的7%。

DeepSeek-V3之所以有如此优秀的表现,主要得益于其高效架构设计(如多头潜在注意力和混合专家架构)、低精度训练以及优化的流水线并行策略。这种突破有力地证明了人工智能的进步与高能耗、高碳排并非必然挂钩,让我们看到了AI技术创新的无限潜力。

尽管目前AI模型训练和动画特效制作都是现代科技的“耗电大户”,但DeepSeek-V3以其高效能低能耗的突破,昭示了科技进步与创新正逐步重塑这一现状,引领行业走向更加绿色可持续的未来。

千瓦科技公众号

千瓦科技视频号

用手机微信扫一扫

您所计算出的排碳量为: kg

为了抵消 您的碳足迹,需种树

棵